Escroquerie 2.0 : l’IA face-swapping sévit en Chine

En Chine, l’escroquerie atteint des sommets encore insoupçonnés. Dans un pays où tout est enregistré, où le crédit social fait loi, des caméras de surveillance à la reconnaissance faciale, cette montée en puissance de l’escroquerie est impressionnante. À l’heure de la communication comme arme de guerre, de propagande, où tout passe sur les réseaux, que le tribunal populaire dépasse le judiciaire, que penser de cette vague qui sévit en Chine ? Est-il possible qu’elle arrive en Europe, voire en France ?

Une affaire anodine de prime abord, pourtant, elle prodigue écho aux vols de données à travers le monde. Imaginez vous recevez un appel ! C’est votre mère au téléphone. La liaison est mauvaise, votre téléphone portable est sur un réseau saturé, vous n’êtes plus en 5G. Elle passe sur un chat pour discuter. Elle à besoin que vous transfériez de toute urgence une forte somme d’argent sur sa carte bancaire. Bizarre, mais c’est votre mère. En plus vous avez reconnu sa voix, son numéro de téléphone, alors sereinement vous effectuez le transfert… vous venez de vous faire escroquer.

C’est à peu de chose près, la mésaventure subit par Dang Yangyu, habitant de Jinan, capitale du Shandong. Fin juin 2023, Zhang Zhenhua, chef d’escadron de la brigade de police criminelle du Bureau de la sécurité publique du comté de Shanghe, présentait l’affaire au journaliste du New Beijing News : « Il s’agit de la récente popularité de la “fraude à l’IA”, un moyen frauduleux consistant à utiliser la technologie intelligente de l’IA pour commettre des escroqueries. »

Des données volées exploitées, du deepfake et la fraude au dumping peut commencer. Ou bien pour vous amuser tout simplement de nombreux outils sont disponibles en ligne.

Selon Fang Yangyu, la police criminelle de Shanghe s’est rendue dans le Guangdong, où l’on soupçonne Xie Mou et trois autres personnes d’avoir aidé à commettre des crimes par lettre. L’affaire fait actuellement l’objet d’une enquête. (Crédits : Sécurité publique de Jinan)

Un appel de 7 secondes

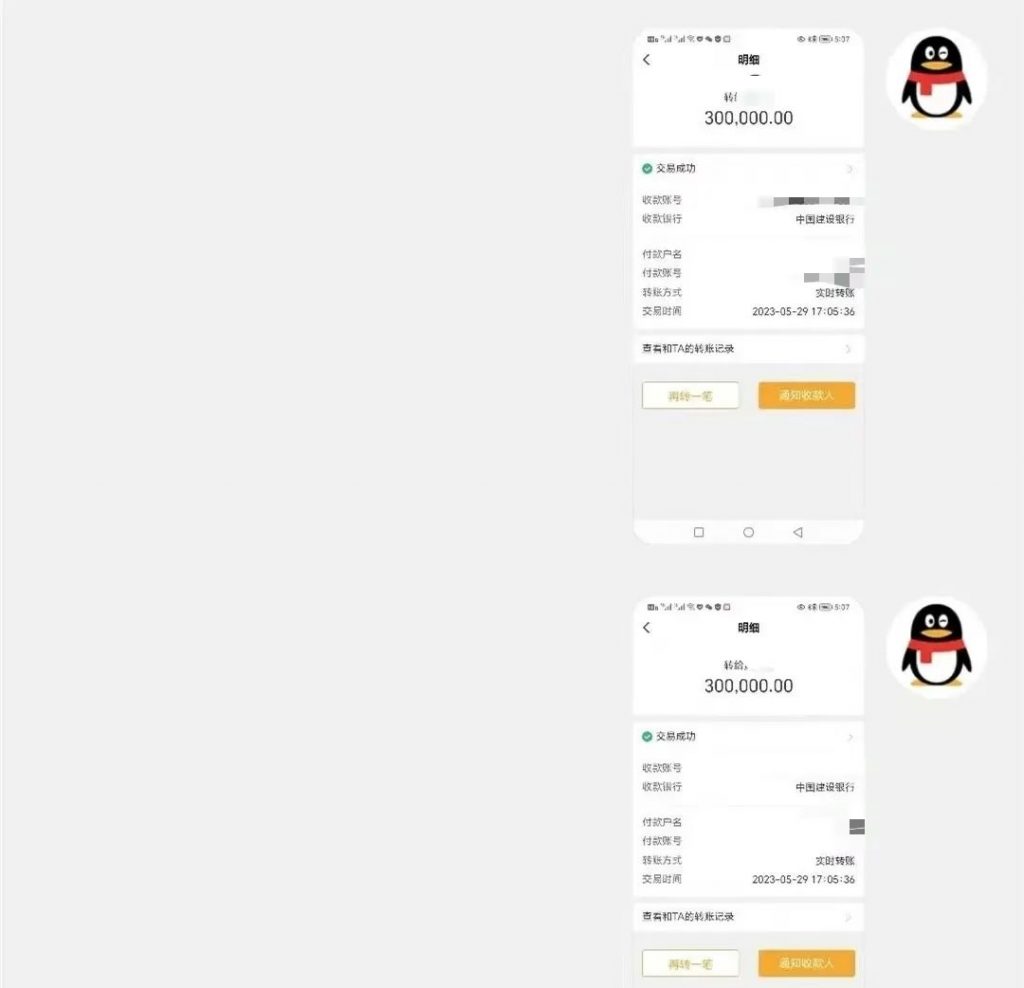

Un appel vidéo de 7 secondes suffit à Fang Yangyu pour transférer 300 000 yuans, près de 39 000 euros. Le 29 mai 2023, Fang Yangyu, regardait des vidéos chez lui à Jinan quand il reçoit un message d’un inconnu. Celui-ci se présente comme un membre de sa famille. Il lui envoie des identifiants QQ. (une application de messagerie gratuite et populaire en Chine). Dans cet appel en visio, la voix et le visage de son « grand frère » sont reconnus. Évoquant la mauvaise qualité de l’appel, le tiers raccroche. La discussion se poursuit par chat.

La personne indiquait qu’elle avait besoin de transférer une somme d’argent de toute urgence ne pouvant directement payer. Ainsi il voulait d’abord transférer de l’argent à Fang Yangyu, puis qu’il transfère l’argent à son tour sur la carte bancaire désignée. Le soi-disant « grand frère » insiste lourdement auprès de Fang Yangyu pour qu’il avance l’argent. Le harcèlement finit par payer.

Il cède en transférant 300 000 yuans sur ledit compte. Une demande supplémentaire de 350 000 yuans était faite. C’est à ce moment-là qu’il se remémore la propagande antifraude. Il appelle en toute hâte ses proches, pour découvrir que tout était faux.

En attendant de se présenter à la police, il s’est aperçu que la vidéo exposant le visage familier était « fausse ». Les criminels utilisaient la technologie de l’intelligence artificielle pour synthétiser l’image de la vidéo.

Un homme de Jinan, Fang Yangyu, a été confronté à une fraude à l’IA, 7 secondes après la vidéo, il a transféré 300 000 yuans sur un compte désigné par le criminel, comme le montre la capture ci-contre. (Crédits : Sécurité publique de Jinan/Weixin)

Reconnaissance faciale en France

Le lundi 12 juin 2023, par 226 voix contre 117, le Sénat adoptait la proposition de loi destinée à « expérimenter » pour une durée de trois ans le recours à la reconnaissance faciale dans l’espace public. Marc-Philippe Daubresse se voulait rassurant sur le fait de ne pas tomber dans une société de surveillance. Des lignes à ne pas franchir sont délimitées, avant qu’il ne cite : « Interdiction de la notation sociale, interdiction de la catégorisation d’individus en fonction de l’origine ethnique, du sexe ou de l’orientation sexuelle sauf s’il s’agit de recherches scientifiques ».

Le sénateur poursuivait en projetant de nouvelles interdictions sur « l’analyse d’émotions sauf à des fins de santé ou de recherche, la surveillance biométrique à distance en temps réel sauf exception très limitées avec des garanties considérables ». Sauf qu’une fois que la porte est ouverte, les personnes malveillantes peuvent s’immiscer et utiliser les données à mauvais escient. D’autant que le vol des données peut engendrer des usurpations d’identité, chantages aux vidéos.

L’hypertrucage comme levier d’extorsion

L’hypertrucage, ou deepfake est l’utilisation de l’IA pour diffuser de l’information mensongère, canulars malveillants ou destructeurs de réputations et e-réputations. Si l’outil qu’est le deepfake n’est pas dangereux en soi, c’est son utilisation qui peut engendre de graves problèmes. L’hypertrucage est le fait de remplacer le visage d’une personne sur le corps d’une autre. Cette méthode est de plus en plus utilisée pour créer des contenus pornographiques. Selon Sensity, 96 % des vidéos concernent les femmes. Le but est, pour des sommes souvent dérisoires, la marchandisation de visages d’actrices, ou encore une « extorsion » envers les publics les plus sensibles.

Certains vont même plus loin. Ils utilisent les données en libre accès d’enfants, adolescentes et adolescents sur les différents réseaux sociaux pour créer de la pornographie juvénile. Au Canada, la Justice rendait en avril 2023 un verdict de 8 ans d’emprisonnement pour détentions de fichiers pédopornographique. Steven Larouche possédait sur son ordinateur 545 000 fichiers, dont 86 000 créées, par hypertrucage.

Le juge Gagnon est revenu sur les 86 000 fichiers produits grâce à la technologie de l’hypertrucage. Car elle permet « d’intégrer le visage d’une personne sur le corps d’un autre individu dans une séquence vidéo ». En utilisant un logiciel, Larouche réussissait à créer des fichiers dont il est « impossible de distinguer le vrai, du faux », écrivait le magistrat. (Crédits : Pexels/Pixabay)

Ping : Tensions dans le cyberespace ? - Libre Expression